2 posts tagged with "GCS"

View All Tagsnetkeiba のデータをスクレイピングして LOD 化する(6)

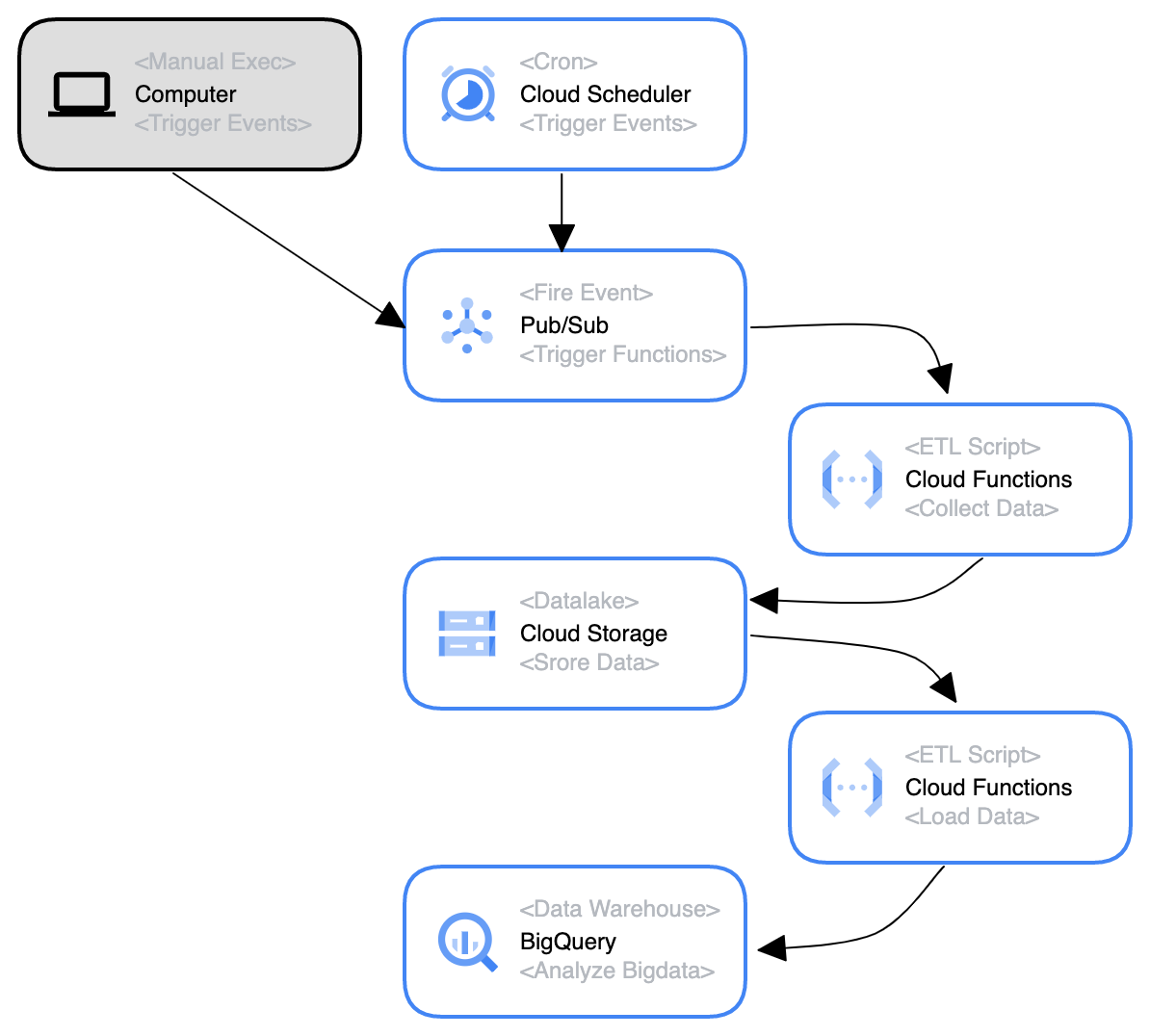

ML4Keiba に関する昨年の記事でも書いたように、ローカルだけでなくクラウド側にデータを保存し、それらをクラウド上の DB におさめて分析あるいはサービス提供できるようにしたいと考えている。

そんな折、以下の書籍を読む機会があり、そこでおおよその方向性がつかめたのでそれをまとめる。

一言で言えば、 Cloud Functions x GCS x BigQuery で DWH をつくる構想 といったところだろうか。